Sobre la corporeidad de los robots

En cualquier caso, llamémosle corporeización o por su denominación en inglés, 'embodiment' se trata de un asunto al que muchos roboticistas y también muchos neurocientíficos conceden capital importancia, los primeros, evidentemente, por su aplicación en robots, los segundos por su importancia en seres vivos y particularmente en el ser humano.

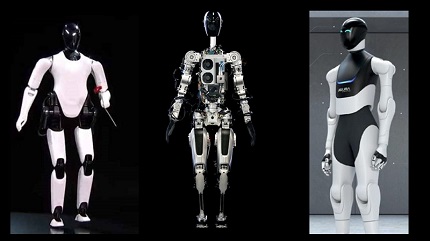

Para muchos roboticistas, esa corporeidad, ese 'embodiment' como ya vimos, es definitorio del concepto de robot e impacta de forma directa en muchas de sus tareas cognitivas e, incluso, algunos neurociencientíficos y roboticistas consideran que es imprescindible para el nacimiento de la consciencia.

El anclaje del lenguaje

En este artículo quisiera revisar una derivada de esta corporeización y que, quizá, sea menos intuitiva: la relación entre el cuerpo y la realidad física con el lenguaje.

Y lo hago basándome en el capítulo que sobre Human Robot Interaction (HRI) firma Tony Belpaeme en el libro 'Cognitive robotics' editado por Angelo Cangelosi y Minoru Asada y también en algún apunte procedente del libro 'Introduction to AI robotics' de Robin R. Murphy.

En la primera de las fuentes se comentan los grandes sistemas de procesamiento de lenguaje natural, en concreto, se cita GPT-3, pero se recalca que este tipo de soluciones NLP ('Natural Language Processing') y, a pesar de la existencia de toda una rama denominada entendimiento del lenguaje natural (NLU, 'Natural Language Understanding') realmente no entienden nada de lo que 'hablan' o 'escuchan', no al menos en el sentido en que los humanos entendemos el lenguaje.

Y dan una razón que enlaza con el discurso de la corporeidad: que en este tipo de sistemas, las palabras no están ancladas ('grounded') al mundo real.

Y eso, nos hacen ver, es completamente diferente a lo que hacemos los humanos que, lógicamente, sí que entendemos en sentido profundo, las palabras. En concreto, y comparando estos sistemas NLP con el leguaje y cognición humana, nos dice;

The contrast with human cognition could not be greater: all the words and linguistic constructions we use are grounded in sensory reality

Es decir, sin un mundo físico al que anclar las palabras y sin unas entradas sensoriales que nos proporciona nuestro cuerpo, es imposible ese anclaje del lenguaje en el mundo, ese dar sentido a las palabras, y un verdadero entendimiento del lenguaje.

Robots y lenguaje. 'Grounding'

Y, en efecto, desde el punto de vista de la robótica, en cierto sentido se recoge ese guante procedente de las ciencias cognitivas.

En su libro, 'Introduction to AI robotics', Robin R. Murphy comenta cómo los robots disponen, para entender y moverse por él, de un modelo del mundo ('world model'), una estructura de conocimiento dotada de símbolos y etiquetas, y en el que elementos del mundo real reciben esa representación y esas etiquetas. Nos dice la autora:

The process of assigning symbols to objects or concepts is called symbol grounding in cognitive science. Robotics concentrates on physical symbol grounding, where data acquired abut the physical world from sensors are assigned to symbols.

Y más adelante añade:

Physical symbol grounding involves anchoring, assigning labels to perceptual inputs and thus anchoring perception to a common frame of reference that can be used by the deliverative functions of the robot

Es decir, se apuesta por esa asignación de etiquetas a lo percibido sensorialmente del mundo real.

Y, en efecto, se nos describen algunas experiencias con robots intentando conseguir un aprendizaje en que los robots asignen esas etiquetas linguisticas a los objetos y realidades que perciben (a una de esas experiencias corresponde la imagen de portada).

¿Qué pasa con los agentes conversacionales?

Si eso es así, ¿Qué pasa con los robots conversacionales, con los chatbots, los voicebots etc? Bueno, en sus implmentaciones habituales, simplemente se adhieren a lo comentado al respecto de GPT-3: hacen uso del lenguaje, un uso cada vez más sofisticado y 'natural' del lenguaje, pero, si no añadimos nada más, no van a 'entender' realmente aquello lo que 'hablan', proporcionan una interfaz muy eficaz, pero no un verdadero entendimiento. Nos dice Belpaeme:

A chatbot can utter phrases about feelings or the weather, but it does not really understand what it is talking about. It has never experienced feelings or weather; or any other words for that matter.

Es decir, el chatbot no entiende, en el sentido profundo del término, aquello de lo que habla. Y el motivo, en el fondo, ya lo sabemos, pero dejemos que sea Belpaeme quien nos lo exprese:

The words that a chatbot uses are not grounded. Grounding happens when words and linguistic expressions area experienced and from that become meaningful.

Eso es. Esas palabras carecen de anclaje, de contrapartida física y sensorial.

Conclusiones

El tema del anclaje del lenguaje y la eventual relación de este con la realidad física, me parece un tema interesantísimo y puede ser un aspecto importante a tener en cuenta si queremos conseguir máquinas más inteligentes y, en cierto sentido, más conscientes (sin extremar el significado de esta palabra).

Sin embargo, y como ya insinué en el artículo sobre 'embodyment', le estoy dando vueltas a algunas matices y reservas sobre esta exigencia de 'corporeidad' y de anclaje físico, pero, como entonces, me las reservo hasta que las tenga más claras y estructuradas.