Aunque no es difícil intuir qué queremos decir cuando hablamos de la explicabilidad de la inteligencia artificial (XAI, eXplainable Artificial Intelligence) o de que un algoritmo sea explicable, cuando intentamos trasladar eso a la práctica, la definición o el objetivo pueden no estar tan claros.

Así que puede ser interesante examinar textos que entren en más detalles o que clarifiquen un poco más lo que pretendemos.

Dos fuentes de información

Finalizando la lectura del libro 'Artificial Intelligence. A modern approach' de Stuart Russell y Peter Norvig me he encontrado una mención muy rápida, como 'muy de pasada', a cuatro características a que aspiramos en una explicación para considerarla buena. En su última edición, este libro fue publicado en Mayo de 2021.

Además, hace unos pocos meses, en Septiembre de 2021, el NIST (National Institute of Standards & Technology) norteamericano publicaba el documento 'NISTIR 8312 Four Principles of Explainable Artificial Intelligence' que recoge una propuesta de cuatro principios para la explicabilidad de la inteligencia artificial.

Comparando ambas propuestas se observa una enorme similitud aunque no completa identificación. Aunque no veo autores comunes entre ambas fuentes, cabe pensar que hay algún tipo de influencia mutua o un 'estado del arte' generalizado del sector.

Ahora pasamos revista con un poquito más de detalle a ambas visiones pero, en mi entendimiento, se trata de dos propuestas muy similares, con la salvedad de que, en el caso de la propuesta del NIST, se fusionan en una sola dos de las características del libro y, a cambio, añaden otra nueva.

El resultado, eso sí, sigue siendo cuatro.

Los cuatro principios para una buena explicabilidad

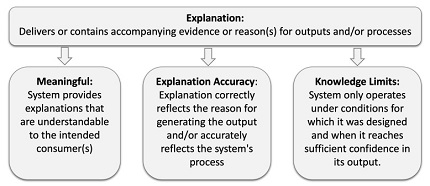

La siguiente figura, tomada del documento del NIST, esquematiza los cuatro principios:

Esos cuatro principios que propone el NIST y que se recogen en la figura son:

- Explicación ('Explanation'): es decir, que el algoritmo explicable implica que debe ser capaz de proporcionar evidencias, razonamientos o soporte de algún tipo que justifique sus conclusiones. Se trata, quizá, de casi una definición de lo que es explicabilidad y se adopta, según reconocen los autores, una visión amplia, capaz de acomodarse a diferentes situaciones.

- Significado ('Meaningful'): significa que la explicación debe ser proporcionada de tal manera que sea comprensible por el receptor de esa explicación, un receptor o receptores que, por supuesto, pensamos sean seres humanos. Además, añaden un matiz, y es que, dado que pueden existir diferentes colectivos receptores de explicaciones, con diferentes 'backgrounds' y objetivos, las explicaciones deben adaptarse a esas diferentes audiencias y objetivos.

- Precisión ('Explanation Accuracy'): implica veracidad, es decir, que la explicación refleje correctamente y de manera precisa la forma en que el algoritmo obtiene sus resultados. Además, se pueden exigir diferentes niveles de detalle según la situación.

- Límites ('Knowledge limits'): implica que el sistema, el algoritmo, no funcione nunca fuera del ámbito para el que ha sido diseñado, que no se superen sus límites o alcance. Además, parece esperarse que el propio algoritmo sea quien identifica cuándo se ha superado su ámbito de aplicación.

Sólo por comparar, ¿Cuáles son las características que se identifican en el caso del libro de Russell y Norvig? o, mejor dicho, ¿Cuáles consideran ellos que son las propiedades de una buena explicación? Pues las cuatro siguientes:

- Debe ser comprensible y convincente para el usuario

- Debe reflejar de manera precisa el razonamiento del sistema

- Debe ser completa

- Debe ser específica en el sentido de usuarios diferentes con diferentes circunstancias o diferentes resultados, deberían obtener explicaciones diferenciadas.

Se observa claramente como coinciden ambas propuestas en la precisión de la explicación, en su comprensibilidad y especificidad (aunque en el caso del NIST esto se condensa en la característica 'meaningful'). No tengo más información de qué quieren decir Russell y Norvig exactamente al pedir la completitud pero tendería a asimilarla con la característica 'explanation' del NIST. Según eso, las dos propuesta casi coincidirían con la salvedad de que el NIST añade el reconocimiento y aplicación de los límites del algoritmo.

Comentarios sobre deseabilidad y factibilidad

Centrándome, por tanto, en la propuesta del NIST, diría que la característica 'explanation' es, como decía más arriba, casi una definición de que es la explicabilidad de un algoritmo.

Respecto a la precisión, si la considerásemos de manera aislada, sería una característica muy fácil de conseguir, dado que, como explicaba en mi post 'Los algoritmos de inteligencia artificial sí saben explicarse', los algoritmos de Inteligencia Artificial, si tomamos una foto fija en el tiempo, son perfectamente deterministas y, en consecuencia, no tenemos más que trasladar las leyes de ese determinismo (perfectamente conocidas por sus diseñadores) a una explicación, quizá matizada por información adicional del valor de los parámetros del algoritmo en el momento de tomar la decisión.

El gran problema de la explicabilidad, y como también explicaba en mi artículo citado, es la llamada característica de 'significado', que esa explicación sea comprensible por humanos. Además, se nos complican un poco más las cosas cuando se pide que esa explicación se adapte a diferentes colectivos y objetivos. Éste es realmente el problema y la enorme dificultad técnica para conseguir la explicabilidad en el caso de los llamados algoritmos de 'caja negra' donde caen áreas tan importantes y relevantes de la inteligencia artificial como es el 'deep learning'.

No sólo es que esa explicación sea significativa (comprensible por humanos) es ya de por sí un gran reto técnico para el caso de algunas familias de algoritmos. Es que, además, se agrava por la anterior petición de precisión, de reflejar de manera fiel, la forma en que el algoritmo alcanza sus resultados. Si, como es el caso del deep learning, la manera de razonar del algoritmo es absolutamente diferente a como razona un humano y de muy difícil comprensión por éste ¿Cómo podemos conjugar la precisión con la 'comprensibilidad' por un humano?

Aunque confío muchísimo en el ingenio humano, y en la capacidad de matemáticos, ingenieros y científicos de datos para encontrar soluciones a problemas complejos el tema no es nada sencillo. O encontramos una tercera vía (lo ideal, pero no sé si posible es encontrar algoritmos con la misma o mayor potencia que el deep learning pero directamente explicables), o relajamos alguna condición o, si no, rozamos la imposibilidad. Pero, insisto, confío muchísimo en ese ingenio, así que no demos nada por perdido, no abandonemos la esperanza y sigamos trabajando.

Tengo menos clara actualmente la problemática de los límites. No me parece difícil, al menos en la mayoría de los casos, un establecimiento de límites donde el algoritmo ya no debería actuar pero siempre que eso sea vigilado por un humano. Si es el propio algoritmo el que debe detectarlo creo, a bote pronto y sin más investigación ni análisis, que en algunos casos será perfectamente viable pero que habrá otros muy complicados o con fronteras bastante difusas.

Conclusión

Las cuatro características que propone el NIST son lógicas y bastante comprensibles... pero no claramente aplicables hoy día en muchos casos.

Como de una forma u otra ya he manifestado en anteriores artículos, la explicabilidad de la inteligencia artificial es una aspiración que se entiende desde un punto de vista ético e incluso legal, pero que tiene unas profundas dificultades técnicas que conviene conocer y, probablemente, gran parte de la solución sea también técnica, en la medida que se consiga rediseñar algoritmos o identificar otros nuevos que satisfagan las aspiraciones éticas y normativas.

Mientras se consigue o no, creo que hay que ser realistas y pragmáticos y exigir la explicabilidad donde realmente sea necesaria, pero probablemente no hacerlo de manera general e indiscriminada.

No hay comentarios:

Publicar un comentario